Egy nyílt levél több száz kutató, Nobel-díjas és technológiai vezető aláírásával figyelmeztet: a szuperintelligens mesterséges intelligencia „megtörheti az emberi civilizáció operációs rendszerét.” Ha a kezdeményezés támogatást kap, az alapjaiban rajzolhatja át a globális technológiai versenyt, különösen az Egyesült Államok és Kína között.

A levél, amely megállítaná a MI-fejlesztés következő szintjét

A Future of Life Institute által kiadott nyílt levél több mint 850 neves szakember aláírásával arra szólítja fel a kormányokat, hogy tiltsák be a szuperintelligencia fejlesztését, legalább addig, amíg nem születik széleskörű tudományos és társadalmi konszenzus a biztonságos megvalósításról.

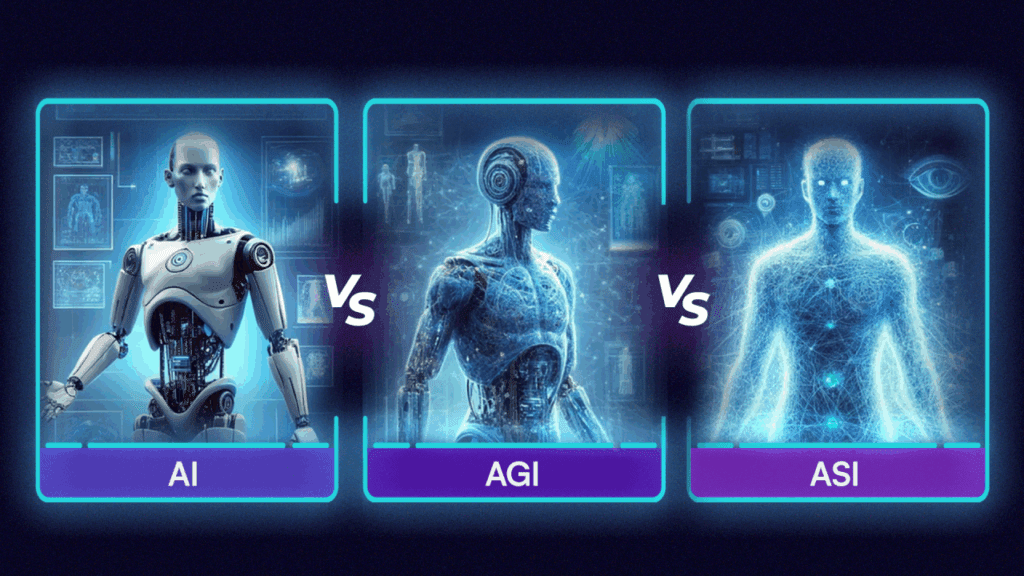

A levél szerint a szuperintelligens rendszerek „minden emberi képességet meghaladó” kognitív teljesítményre lesznek képesek, azaz önálló döntéseket hozhatnak, átírhatják saját kódjukat, és emberi felügyelet nélkül működhetnek.

Az aláírók között olyan nevek szerepelnek, mint Geoffrey Hinton és Yoshua Bengio, a mélytanulás úttörői, Steve Wozniak, az Apple társalapítója, valamint Susan Rice, az Obama-kormány nemzetbiztonsági tanácsadója. Az aláírók politikai sokszínűsége azt mutatja, hogy a MI szabályozása már nem ideológiai, hanem civilizációs kérdés.

„A szuperintelligencia felesleges és veszélyes”

A történész és író Yuval Noah Harari, a levél egyik aláírója így fogalmazott:

„A szuperintelligencia valószínűleg megtörné az emberi civilizáció operációs rendszerét és teljesen felesleges. Ha ehelyett az irányítható, emberközpontú MI-eszközökre fókuszálunk, biztonságosabban élvezhetjük a technológia előnyeit.”

A levélből feltűnően hiányoznak a jelenlegi MI-óriások vezetői: sem az OpenAI, sem az Anthropic, sem a Google, Meta vagy Microsoft nem szerepel az aláírók között, ami egyre mélyebb szakadékot jelez a fejlesztők és a korlátozást sürgetők között.

Milliárdok a jövő intelligenciájába

A vitát az teszi különösen feszültté, hogy közben a nagyvállalatok soha nem látott összegeket fektetnek a MI-infrastruktúrába. A Meta idén júniusban 14,3 milliárd dollárt invesztált az új Superintelligence Labs projektbe, az OpenAI pedig januárban jelentette be, hogy a fejlesztések fókusza a szuperintelligencia irányába tolódik.

Ez már a második alkalom, hogy a Future of Life Institute hasonló felhívást indít. A 2023-as, GPT-4 utáni fejlesztéseket hat hónapra befagyasztani kívánó levél több mint 30 000 aláírást gyűjtött, de az iparág figyelmen kívül hagyta.

A szakértők szerint ez egyelőre távoli veszély

A technológiai elemzők szerint a szuperintelligencia még mindig elméleti kockázat, nem pedig gyakorlati vállalati probléma. Sanchit Vir Gogia, a Greyhound Research vezérigazgatója szerint:

„A szuperintelligencia legkorábban évtizedes távlatban jelent valós fenyegetést. A vállalatoknak most a jelenlegi MI-rendszerek biztonságos és skálázható működtetésére kell koncentrálniuk.”

Szerinte a cégeknek adatkormányzási, átláthatósági és validálási gyakorlatokat kell erősíteniük, a „világvége-MI” kérdését pedig a szabályozóknak és etikusoknak kell kezelniük.

A szuperintelligencia tilalma átírná a globális versenyt

Ha a javaslatot elfogadnák, az átalakítaná a technológiai erőviszonyokat. A szigorú korlátozások az amerikai „frontier labokat”, például az OpenAI-t vagy az Anthropicot lassításra kényszerítenék, miközben előnybe hozhatnák azokat a fejlesztőket, akik biztonságosabb, kisebb és átláthatóbb modellekben gondolkodnak.

A Gartner szerint a globális MI-kiadások 2025-ben elérhetik az 1,5 billió dollárt, és 2026-ra meghaladhatják a 2 billiót. Az IMF úgy becsüli, hogy a mesterséges intelligencia évi 0,5%-kal növelheti a globális GDP-t 2030-ig.

Egy esetleges tiltás azonban gazdasági lassulást és stratégiai előnyvesztést is okozhat az Egyesült Államoknak, főleg Kínával szemben, amely az exportkorlátozások ellenére is gyors ütemben fejlődik.

A DeepSeek és az Alibaba már olyan nyílt forráskódú modelleket fejlesztett, amelyek felzárkóztatják Kínát a nyugati kutatásokhoz.

Felelősségvállalás vállalati szinten

Ha a tiltás nem valósul meg, ahogy 2023-ban sem történt, a szakértők szerint a szabályozási felelősség a vállalatok szintjére kerül. A Greyhound Research szerint a CIO-knak belső MI-irányítási rendszereket kell létrehozniuk, beleértve:

- AI-etikai tanácsok felállítását,

- incidenskezelési protokollokat,

- valamint olyan szállítói szerződéseket, amelyek előírják az adatkészletek átláthatóságát és auditálhatóságát.

Gogia szerint a jövő kulcsa az ellenőrizhető, felelősen működő MI, nem pedig a mindenható szuperintelligencia.

Egy korszak határán

A nyílt levél újraéleszti a kérdést: kell-e félnünk a saját teremtményeinktől? A szuperintelligencia még nem valóság, de a róla szóló vita már most meghatározza, milyen jövőt építünk, olyat, ahol az MI partner, vagy olyat, ahol az emberiség csak néző lesz.