A cikkben bemutatunk 5 ingyenesen elérhető, nélkülözhetetlen szakmai könyvet, amelyek lefedik a nyelvi modellezés elméleti, rendszerszintű, nyelvészeti, értelmezési és biztonsági oldalát.

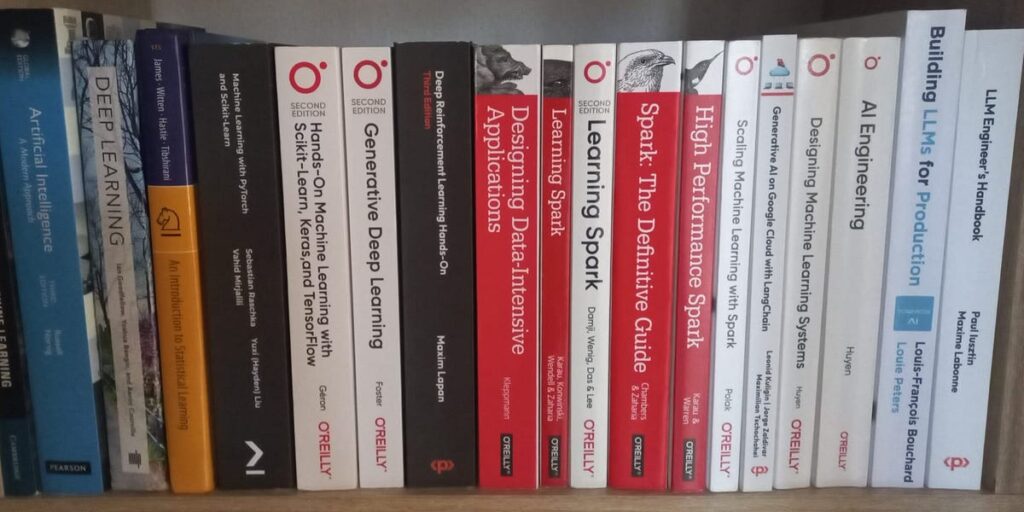

Kötelező olvasmány minden nyelvi modellezéssel foglalkozó mérnöknek

Sokan szeretnék mélyebben tanulmányozni a nyelvi modelleket. A kurzusok és cikkek hasznosak az általános ismeretek megszerzéséhez, de az igazi mélységhez könyveket kell olvasni. A könyvekben az a jó, hogy van szerkezetük: logikus sorrendben, átlátható módon épülnek egymásra, szemben az online tanfolyamokkal, amelyek sokszor szétszórtak.

5 ingyenesen elérhető, de valóban értékes könyvet ajánlunk különböző szakmai területekre.

Ha komolyan érdekel, hogyan működnek a nagy nyelvi modellek, ezekkel a könyvekkel érdemes kezdened.

1. Foundations of Large Language Models

A Foundations of Large Language Models című könyv 2025 elején jelent meg, és az egyik legáttekinthetőbb, legkoherensebb szakmai mű azok számára, akik ténylegesen meg akarják érteni, hogyan épülnek, tanulnak és hangolódnak a modern nyelvi modellek. A szerzők, Tong Xiao és Jingbo Zhu, a természetes nyelvfeldolgozás elismert kutatói. A könyv nem a legújabb trendeket ismerteti, hanem a modellek mögötti alapmechanizmusokat magyarázza: hogyan működik a GPT, a BERT vagy a LLaMA. A hangsúly a fogalmi tisztaságon és a rendszeres gondolkodáson van:

- mit jelent a pre-training valójában,

- hogyan működnek belülről a generatív modellek,

- miért fontos a promptolási stratégia,

- és mit takar a „hangolás” fogalma, amikor az emberi beavatkozás célja a gépi viselkedés finomítása.

Ez a könyv ideális azoknak, akik a kísérletezés előtt szeretnének biztos elméleti alapokat építeni. Tartalmi áttekintés:

- Pre-training (alapelvek, paradigmák, alkalmazás és adaptálás gyakorlata)

- Generatív modellek (dekóder-alapú transzformerek, adat-előkészítés, skálázási szabályok, hatékonyság)

- Promptolás (jó promptok tervezése, fejlett technikák, optimalizálási módszerek)

- Hangolás (RLHF, instrukcióalapú tanítás, jutalmazási modellek)

- Inference (dekódolási algoritmusok, értékelési mutatók, hatékony inferencia)

2. Speech and Language Processing

Ha valaki mélyebben szeretné megérteni a nyelvi feldolgozást, akkor Daniel Jurafsky és James H. Martin műve, a Speech and Language Processing az egyik legjobb forrás. A 3. kiadás 2025 augusztusában jelent meg, és teljes egészében lefedi a modern nyelvfeldolgozást: transzformereket, nyelvi modelleket, automatikus beszédfelismerést (Whisper), valamint a szöveg-beszéd rendszereket (EnCodec, VALL-E). A könyv lépésről lépésre halad: a tokenizálástól és beágyazásoktól kezdve egészen a modellek tréningezéséig, hangolásáig és párbeszédes szerkezetekig. A tervezet PDF-változata ingyenesen elérhető.

Tartalmi áttekintés:

I. kötet – Nagy nyelvi modellek

- 1–2. fejezet: alapok, szavak, tokenek, Unicode-kezelés

- 3–5. fejezet: n-gram modellek, logisztikus regresszió, vektorbeágyazások

- 6–8. fejezet: neurális hálók, transzformerek, tréningtechnológiák

- 9–12. fejezet: utóhangolás, maszkolt nyelvi modellek, RAG, gépi fordítás

- 13. fejezet: RNN és LSTM modellek

14–16. fejezet: fonetika, beszédfelismerés (Whisper), szöveg-beszéd rendszerek (EnCodec, VALL-E)

II. kötet – Nyelvi szerkezet annotálása

- 17–25. fejezet: szekvenciajelölés, NER, függőségi elemzés, információkinyerés, szemantika, koherencia, diskurzus és párbeszédszerkezet

3. How to Scale Your Model: A Systems View of LLMs on TPUs

A nagy modellek tréningje összetett: hatalmas adatok, drága hardver, nehezen azonosítható szűk keresztmetszetek. A How to Scale Your Model: A Systems View of LLMs on TPUs című anyag rendszerszemléletben mutatja be, hogyan működnek a Tensor Processing Unitok (TPU-k) és GPU-k, hogyan kommunikálnak, és miként lehet a modelleket hatékonyan futtatni valós környezetben. Az írók maguk is ipari rendszereken dolgoztak (Google), így a magyarázatok a gyakorlatból erednek.

Tartalmi áttekintés:

- Rooflines (hardverkorlátok: flops, memória, sávszélesség)

- TPUs (működés, többchippes tréning)

- Sharding (mátrixműveletek, kommunikációs költségek)

- Transformer-matematika (flopok, bájtok, metrikák)

- Tréning (adat-, tensor-, pipeline-párhuzamosítás, FSDP)

- LLaMA tréningpélda TPU-n

- Inferencia (késleltetés, mintavételezés, gyorsítás)

- Modellkiszolgálás (kv-cache, batch-kezelés, latency)

- Profilozás (XLA optimalizálás)

- JAX (hatékony TPU-programozás)

4. Understanding Large Language Models: Towards Rigorous and Targeted Interpretability Using Probing Classifiers and Self-Rationalisation

Ez a könyv nem hagyományos tankönyv, hanem Jenny Kunz doktori értekezése a Linköping Egyetemről. Olyan kérdéssel foglalkozik, amit kevés más munka tárgyal: hogyan érthetjük meg, mit és miért „gondolnak” a modellek. A kutatás két fő irányt vizsgál:

- az információt, amit a modellek rétegei tárolnak (probbing classifiers),

- az önmagyarázó (self-rationalising) modelleket, amelyek szöveges indoklást generálnak saját előrejelzéseikhez.

A dolgozat bemutatja, mely tulajdonságok teszik az ilyen magyarázatokat hasznossá, melyek segítik az emberi megértést, és hogyan lehet a modelleket átláthatóbbá tenni.

Tartalmi áttekintés:

- Rétegenkénti elemzés probing osztályozókkal (információtartalom, módszerek, új mérési megközelítések)

- Önmagyarázó modellek (magyarázatok generálása, emberi értékelés, hasznosság és érthetőség összevetése)

5. Large Language Models in Cybersecurity: Threats, Exposure and Mitigation

A nagy nyelvi modellek nemcsak lehetőségeket, hanem kockázatokat is hordoznak: adatvesztés, adathalászat, kódsebezhetőség. A Large Language Models in Cybersecurity: Threats, Exposure and Mitigation című könyv ezeket a veszélyeket és a védekezés lehetőségeit ismerteti. A szerzők konkrét példákat mutatnak be a társadalmi manipulációtól a biztonságos rendszerhasználatig. Különösen értékes, mert a legtöbb könyv nem foglalkozik a nyelvi modellek kiberbiztonsági oldalával.

Tartalmi áttekintés:

- Bevezetés (működés, korlátok, értékelési módszerek)

- Kockázatok (adatkiszivárgás, adathalászat, kódbizonytalanság, befolyásolási kampányok)

- Kitettség és követés (kutatási trendek, jogi kérdések, befektetési és biztosítási aspektusok)

- Védelem (adatbiztonság, oktatás, támadások elleni védekezés, piros csapatok, biztonsági szabványok)

- Összegzés (a modellek kettős szerepe: kockázat és védelem)