Egy friss felmérés szerint a válaszadók kilencvenhét százaléka képtelen felismerni, ha egy dalt a mesterséges intelligencia alkotta. De vajon számít ez egyáltalán, ha úgyis tetszik, amit hallasz?

Amikor a hősöd nem is ember

Van egy új szám amit nem tudsz kiverni a fejedből. Újra és újra hallgatod, megosztod a barátaiddal, és már azon gondolkozol, hogy mikor fog koncertezni a kedvenc új előadód a közeledben. Aztán egy nap rájössz: az előadód nem létezik. Legalábbis nem abban az értelemben, ahogy azt gondoltad. Nem egy ember, aki a szobájában gitározik, és a múltja fájdalmából merít. Hanem egy algoritmus, amit valaki arra programozott, hogy pontosan olyan zenét hozzon létre, ami tetszik neked.

Ez a streaming platformok jelenlegi valósága. Egy friss felmérés szerint a válaszadók kilencvenhét százaléka képtelen felismerni, ha egy dal mesterséges intelligenciával készült. És ezt a zeneipar nagyon is tudja. A Deezer bejelentése szerint az általuk feltöltött tartalom harmada, napi körülbelül ötvenezer dal teljesen MI-generált. Ötven. Ezer. Dal. Naponta.

Ez nem arról szól, hogy a zenészek használják az MI-t egy-egy eszközként, ahogy a Beatles tette John Lennon hangjának tisztításával, vagy ahogy Imogen Heap próbálkozik a saját MI-modelljével. Ez arról szól, hogy teljesen szintetikus projektek özönlik el a platformokat, amelyeknek nincs emberi arcuk, nincs történetük, és sokszor nincs más céljuk, mint hogy begyűjtsék a lejátszások után járó filléreket.

A leleplezés anatómiája

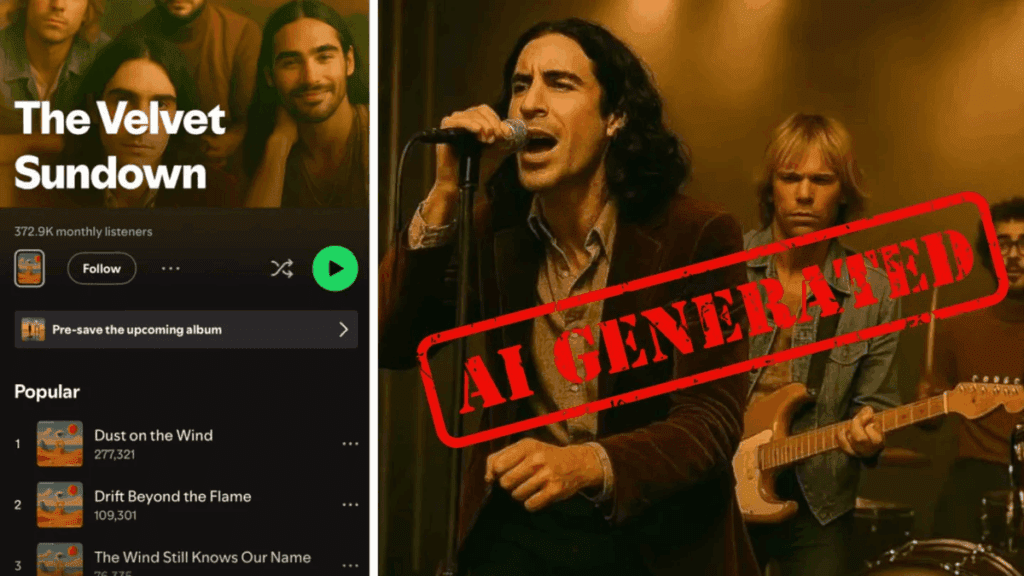

Tavaly nyáron robbant a botrány a The Velvet Sundown nevű zenekar körül, amikor gyanús lett a zenei világnak, hogy valami nem stimmel velük. A banda rekordgyorsasággal töltött fel két albumot a Spotify-ra, és hirtelen százezres hallgatóságot gyűjtött magának. Nem volt kiadójuk, minimális volt a közösségi média jelenlétük, és senki sem találta a nyomát annak, hogy valaha élőben játszottak volna.

Az internetnyomozók gyanakodni kezdtek a banda fotóira, amelyek közös jellemzője a semleges háttér és a meleg narancssárga szűrő volt. Egyetlen koncertfotó vagy videó nem volt fellelhető, a zenekar tagjai nem adtak interjút, és egyéni közösségi média fiókjaiknak sem volt nyoma. Amikor végül szembesítették őket a vádakkal, először tagadtak, aztán beismerték: szintetikus projekt vagyunk emberi kreatív irányítással, amelyet mesterséges intelligencia segítségével komponáltak, énekeltek és vizualizáltak.

Művészi provokációnak nevezték, nem trükknek. A rajongók jelentős része mégis úgy érezte, hogy becsapták őket. De miért? Mi rosszat csinált ez a zenekar? Zenét készítettek, ami embereknek tetszett. Vagy mégsem?

Hogyan ismered fel, hogy MI hallgatsz?

Ha tudni akarod, hogy emberi vagy gépi alkotást hallgatsz, vannak jelek, bár egyre nehezebb megtalálni őket. Az ötéves múltra visszatekintő MI-zene alkotó, LJ Rich emlékei szerint öt éve még csak három másodpercnyi zenét tudott generálni az MI egyszerre, és egy perc hang elkészítése tíz órát vett igénybe. Ma egyetlen paranccsal teljes dal hozható létre pillanatok alatt.

A legtöbb MI-generált dal sablonos érzést kelt. Jó, de nincs benne sem súly, sem érzelmi mélység. A vokálok légszomjasnak tűnnek, a dalszerkezet általában követi a klasszikus versszak-refrén mintát, és ritkán van kielégítő befejezése. Az MI hajlamos nyelvtanilag helyes szövegeket írni, míg az emberek néha olyan sorokat hoznak létre, amelyek nem tökéletesek, de éppen ezért emlékezetesek.

Gondolj csak Alicia Keys concrete jungle where dreams are made of sorára, vagy a Rolling Stones dupla tagadására az I Can’t Get No Satisfaction-ban. Ezek nem nyelvtanilag tökéletes mondatok, de pontosan ezért működnek. Az MI ezt nem érti. Az MI mintázatokat ismer, de nem értelmezi a kontextust és az emberi élményt, ami mögötte áll.

Tony Rigg, zeneipar-szakértő szerint az MI még nem élte át a szívfájdalmat. Ismeri a mintázatokat, de nem a mögöttük rejlő emberi történetet. Az MI énekesek kissé elmosódottan szólalnak meg, a mássalhangzók és explozívák nem teljesen pontos hangzásúak, és kísértet harmóniák jelennek meg véletlenszerűen a háttérvokálokban. Ugyanakkor Rigg azt is hangsúlyozza, hogy ezek csak jelzések, nem bizonyítékok, és egy átlagos hallgató számára korántsem egyszerű felismerni az MI-generált dalokat.

Egy másik gyanús jel az irreálisan magas termelékenység. Amikor egy művész egyszerre több hasonló stílusú albumot dob ki, vagy amikor hetente tömegével jelentkeznek új dalok, az gyanút kelthet. Az egyik nemrég lebukott MI-projekt zenéje úgy hangzott, mintha nyolcvanas évekbeli rockklasszikusokat dobtak volna egy turmixgépbe. Háttérzenének jó lehet, de szupersztárt nem fog csinálni belőle.

Imogen Heap esete: átláthatóság és őszinteség

Vannak azonban olyan előadók, akik nem bujkálnak az MI használata mögött. Imogen Heap múlt hónapban kiadott egy dalt, az Aftercare-t, amelyen az ai.Mogen nevű MI-modellje énekelt. A hangmodellt eredetileg chatbotként hozta létre, hogy lépést tartson a rajongóktól és üzleti partnerektől érkező üzenetek áradatával, de később több dalban is szerepelt, és lehetővé tette számára, hogy időkorlátokon túlmutató együttműködésekben vegyen részt.

Heap szerint aki igazán ismeri a hangját, az hallja a különbséget, de ő sokat dolgozott azon, hogy az MI-verziója emberinek hangozzon, és úgy gondolja, hogy az átlagos hallgató nem venné észre. De Heap nem próbálja megtéveszteni a hallgatókat. Az ai.Mogen név ott van a dal közreműködői listáján. Heap szerint pont az a lényeg, hogy ha az emberek emberi kapcsolatot éreznek a dallal anélkül, hogy tudnák, hogy részben MI énekli, akkor talán újragondolják az MI-vel kapcsolatos negatív előítéleteiket.

Heap transzparenciát követel: ugyanúgy, ahogy a mikróban melegíthető étel csomagolásán olvashatjuk az összetevőket, úgy kellene látni a zenénél is, hogy milyen technológiával készült, és mennyiben használtak MI-t. Ez jelenleg nem kötelező, és egységes rendszer sem létezik rá.

A platformok lépései a transzparencia felé

Jelenleg nincs jogi kötelezettség arra, hogy a streaming platformok jelezzék az MI-generált dalokat, bár egyre nagyobb a nyomás arra, hogy ezt tegyék. A Deezer januárban elindított egy MI-detektáló eszközt, majd nyáron egy rendszert, amely megjelöli az MI-generált zenét. A platform azt állítja, hogy a detektálási rendszere képes azonosítani a leggyakoribb MI-zene készítő eszközökkel létrehozott dalokat. És dolgoznak azon, hogy más eszközöket is képesek legyenek felismerni.

Manuell Moussallam, a Deezer kutatási igazgatója szerint a csapata annyira meglepődött azon, hogy mennyi dalt jelölt meg az eszköz MI-generáltként, hogy először azt hitték, hiba van a rendszerben. Az eszköz gyorsan százszázalékos biztonsággal azonosította a The Velvet Sundown zenéjét MI-generáltként.

A Spotify szeptemberben bejelentette, hogy még idén bevezet egy spam szűrőt, amely azonosítja a rossz szándékú szereplőket. És megakadályozza, hogy a hallgatóknak szemetet ajánljanak. Az elmúlt évben több mint hetvenötmillió spam dalt távolítottak el. A platform emellett támogat egy rendszert, amely lehetővé teszi az előadók számára, hogy jelezzék, hol és hogyan használtak MI-t egy dalban. Ez az információ a dal metaadataiban fog szerepelni, és megjelenik az alkalmazásban. A Spotify szerint ez nem a felelősen MI-t használó művészek büntetéséről szól, hanem a hallgatók információigényének kielégítéséről és a bizalom erősítéséről.

Számít egyáltalán?

Ha beleszerettél egy új előadóba, számít, hogy ember vagy gép készítette a zenéjét? Vannak, akik szerint teljesen irreleváns. A zenének az a célja, hogy élvezzük, és ha valami tetszik, akkor már teljesítette az elsődleges funkcióját. Mások szerint a rajongóknak joguk van tudni, hogy mit hallgatnak, és informált döntést hozni arról, hogy mit támogatnak.

Számos művész mély aggodalmának adott hangot az MI hatásáról. Több száz zenész, köztük Dua Lipa és Elton John tiltakozott amiatt, hogy dalaikat felhasználják MI-eszközök betanítására, kompenzáció és hozzájárulásuk nélkül. A kérdés tehát nem pusztán technológiai, hanem etikai is.

LJ Rich szerint az MI zeneipari jelenléte sok furcsa és gyönyörű etikai kérdést vet fel, amelyekre még nincs válasz. Ha egy dal felállítja a tarkódon a szőrt, akkor számít, hogy egy MI írta vagy sem? Van-e különbség egy algoritmus által generált érzelem és egy emberi tapasztalatból fakadó érzelem között? És ha a hallgató nem képes különbséget tenni, akkor van-e egyáltalán különbség?

A válasz valószínűleg személyes. Vannak, akik számára a zene pusztán szórakozás, háttérzaj, amit futás közben vagy dolgozás közben hallgatnak, és számukra teljesen mindegy, hogy ki vagy mi írta. Mások számára a zene több ennél: kapcsolat, történet, érzelmi élmény, amely egy másik ember belső világába enged bepillantást. És ha ez a másik ember nem is ember, akkor valami elvész belőle.